普法:刑法怎么应对人工智能带来的风险挑战

本篇文章3652字,读完约9分钟

姜涛

人工智能不是真的有意识,也没有适用谴责的意思和惩罚的能力。 因为这个人工智能本身不是适用惩罚的合格主体。 但是人工智能带来的许多风险不容忽视,需要加强人工智能制造者和被录用者的规范意识,从刑法教义学上积极回答人工智能制造者和被录用者的行为与刑法相关的罪名的关系。

人工智能是人类社会的第四次产业革命其高速发展开辟了用新技术支撑新社会结构的人类新时代。 但是,从刑法学角度来看,人工智能带来了什么样的风险挑战,刑法如何合理应对人工智能,需要法律工作者积极思考。

人工智能进入社会生活带来的双重风险

人工智能顾名思义,是能够模仿、扩展、扩展人类思维、活动的技术。 针对人工智能的全球高速发展,年7月国务院发布的《新一代人工智能快速发展计划》强调:“在大力发展人工智能的同时,高度重视可能带来的安全风险挑战,加强预见性的预防和制约诱惑,风险最大 国务院发表的这份文件人工智能定位正确,认为人工智能给我们带来便利,带来迅速的发展,也带来风险。

一是人工智能技术带来的风险。 人工智能现在不完全成熟,有很多缺点。 这些缺陷必然对社会产生一定的风险和严重的影响。 例如,在光线条件不好的情况下,自动驾驶的汽车可能会错误地识别“减速慢速行驶”标志,撞人,导致重大财产损失,自动驾驶系统故障,无法正确收集数据等原因导致驾驶员死亡。 无人机进入客机的飞行路线,引起了严重的安全风险。 请等待利用人工智能进行网络军事攻击。

二是人工智能制造商制造的风险。 公司生产的人工智能产品不仅有因采用大量数据而泄露公民个人新闻等隐私的风险,而且有可能被其他有意者利用来实施犯罪,被用于实施大规模、比较有效的攻击,安全上的担忧 这种风险包括公司违反机器人的制造,或者招聘人员拒绝放弃危险的机器人等。 如果没有严格的控制,这个风险就会辐射到经济、文化、教育等各个行业,带来严重的社会安全问题。

为了适应社会的迅速发展,更好地应对人工智能时代面临的新问题、新挑战,不仅需要解决人工智能有无刑事责任能力,还需要解决刑法教义学上与人工智能相关的犯罪。

人工智能没有刑事责任能力

人工智能对刑法的挑战首先是责任。 很多人对人工智能是否具有刑事责任能力展开了讨论,有否定论的定论。

通过整理人工智能的迅速发展,可知人工智能是“魔法”,但离不开两个必要条件。 一是人工智能离不开大数据的支持。 如果没有足够的数据作为训练样本,人工智能就找不到自己的算法漏洞,没有机会修改算法函数,难免会产生错误。 二是人工智能离不开运算能力的提高和深度学习框架的构建。 深度学习框架在人工智能中起着重要的作用,其原理是构建多层人工神经网络,利用神经生理学知识模拟人的神经活动,然后输入大数据进行训练、学习,根据训练得到的结果 最终模拟人脑的功能通过大量的计算和固定的框架,人工智能更擅长解决规则的事务,但规则改变后情况会大不相同。 这对于人工智能能否成为责任的主体起着重要的作用。 现在是“弱人工智能时代”,人工智能未来的快速发展形象还不明确,但目前人工智能是帮助人做什么有规律、反复的工作的工具,没有真正的意识,不应该具有刑事责任能力

其中之一是人工智能真的没有意识。 根据研究的现状,人工智能首先由人预先设置利益处理步骤,通过大量计算得到不同决定的得分,根据得分的高低选择什么样的行为。 人工智能看起来可以像人类一样自主决定,但这些决定是在设计师预先设定的算法框架下得到的,所谓的“自主性”也是不同决定间的选择,人工智能没有人类智能的所有共同智能。

其二,人工智能没有谴责的意思。 刑罚处罚是一种文化现象,人类社会迄今形成的生命刑、自由刑等有效的是刑罚和被处罚以感知、传播的方法表现,恢复被破坏的社会关系,改变人们的认识,对犯罪受害者满足报复感情,对犯罪者进行忏悔,对社会人民 如果惩罚不能满足这种感情需要,惩罚就毫无意义了。 人工智能是新闻技术革命的产物,本身感受不到刑事处罚的意义,惩罚机器人比直接销毁或销毁更有社会意义。 而且,通过惩罚措施不能消除人工智能带来的风险,也不能达到预防再犯的惩罚目的的期待。

其三,人工智能没有适用惩罚的能力。 惩罚是否适用于剥夺他人的生命、自由等权益,必须考虑惩罚对象的惩罚能力,这是预防犯罪的需要。 这种处罚能力与被处罚者的自由意志有关,目的是让被处罚者认识到处罚带来的痛苦,用疼痛改变前非,重新人性化,消除再犯罪的危险。 从自由意志的角度来看,人工智能的价值体现在工具上,其自由意志是模拟的、虚拟的。 从刑罚能力的角度来看,人工智能作为工具,本身不是自由和财产,而是设计者和采用者的财产,无论是自由刑还是财产刑,都不能对人工智能造成损害,刑罚真正能发挥其抑制、处罚犯罪的功能的只有设计者和采用者。

人工智能的刑法教义学解答

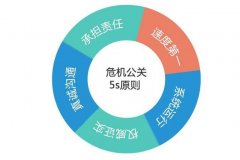

人工智能带来很多风险,受刑法保护的法益有被破坏或破坏的危险,人工智能本身不是处罚适用的合格主体,因此要强化人工智能的制造者和录用者的规范意识,在刑法教义学上加强人工智能的制造者和录用者的行为和刑事

拒绝履行“公司担保人义务”和新闻互联网安全管理义务的罪。 公司必须从人工智能技术训练中遵循谨慎的规则,识别和解决可能发生的危险,履行保证人的义务,保证设计的人工智能技术安全,无缺陷。 如何附加保证人的义务可以参考民法上的规则,设计的人工智能技术必须经过大量充分的实验测试,确保不损害他人的人身或财产安全才能投入市场,否则保证人的义务 对于已经投入市场的人工智能技术,需要关注安全状况,及时召回有缺陷的技术产品,赔偿已经发生的损害。 不履行保证人的义务,就可以进入刑法的限制范围。 具体来说,如果不履行保证人的义务,人工智能扰乱了互联网的秩序,影响了互联网的安全,公司就被认为是人工智能服务的提供者,没有履行新闻互联网的安全管理义务, 适用刑法第286条规定的不履行新闻网络安全管理义务的罪行有罪,或者不履行保证人义务对他的所有人身或财产造成重大损害的,视为未履行危险源管理义务,构成相应犯罪的不作为。

“公司的监督管理失灵了”,非法经营罪的兜风条款的扩大说明。 人工智能是风险和优势并存、专业性强的领域,要从事这个领域,请判断、审查公司的研究开发能力,向评级合格的公司颁发人工智能技术的经营许可证,禁止评级不合格的公司从事人工智能的研究开发 另外,结合事前和事后的审查,建立人工智能的产品许可证和监督制度。 预审由专门机构根据相关安全标准判断人工智能中的数据、算法实现的功能及可能存在的风险,并向判断合格的产品颁发生产、销售许可证,保证人工智能设计上的合法性和安全性。 采用事后审查、登记制度,记录人工智能技术的设计者、被录用者的新闻及其主要功能。 变更第一个算法使功能实质性变化时,需要进行功能变更登录。 转让人工智能技术需要招聘者新闻变更登记。 对违反经营许可制度、产品许可和监督制度的公司,适用刑法第225条第4款非法经营罪的兜底条款作出有罪判决,当然,前提是制定相关的司法解释。

“客户数据”与侵犯市民个人新闻罪。 客户的数据是市民的个人新闻,属于客户自己。 人工智能在发掘和分解大数据时,不能忽视公民个人新闻的保护。 现行法律对民法总则第111条、网络安全法第41条及两高发表的《公民个人新闻刑事案件适用法若干问题的解释》第1条等个人新闻的定义及保护有确定规定,但目前已组成《公民个人新闻》保护 笔者认为应该扩大公民对个人新闻的保护范围。 比如客户的行为方式,公民经常搜索金融资产管理的相关复印件,开始频繁出现在金融资产管理产品链接阅览的网站上。 因为客户的搜索记录被拆除了,有理财的倾向。 同样的消息泄露不会威胁公民的人身、财产安全,但过度分解会侵害公民的隐私空间,使公民的生活透明化。 对此,摆脱公民人身、财产安全的限制,对个人隐私及其他公民生活有重要影响的新闻也必须纳入刑法相关公民个人新闻的保护范围。 对擅自发掘和利用客户个人新闻造成严重后果的行为,可以适用刑法第253条侵犯公民个人新闻罪的定罪。

“不销毁”和以危险做法危害公共安全的罪行。 除了降低人工智能的风险,规范人工智能公司的活动外,还关注非法采用(第一是个人)人工智能技术的现象。 随着人工智能的迅速发展逐渐大众化是人工智能的未来趋势。 这些人工智能产品被非法采用的,应当没收和销毁涉嫌违法犯罪的人工智能产品。 拒绝放弃的,可以适用刑法第114条和第115条以危险的做法作出危害公共安全罪的有罪判决。 这样说明的理由如下: (1)由于近年来发生的无人机导致飞机着陆停止、自动驾驶车路标错误识别导致行人碰撞等现象,人工智能产品具有高风险性,严重影响不特定多数人的人身财产安全,以危险的做法进行公共安全 (2)以危险的做法危害公共安全的罪是自然人犯罪,主体只有自然人。 与公司不同,公民个体在违法采用人工智能产品的情况下,可以以危险的做法成为危害公共安全罪的主体。

(作者是南京师范大学中国法治现代化研究院教授)

标题:普法:刑法怎么应对人工智能带来的风险挑战 地址:http://www.leixj.com/pf/2020/1222/17968.html